时间:2019-03-27 13:22:05 次数:3595

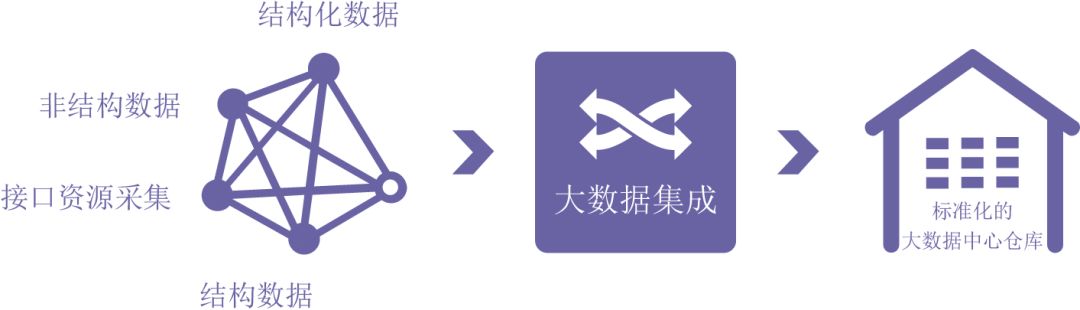

近几十年来,科学技术的迅猛发展和信息化的推进,使得人类社会所积累的数据量已经超过了以往过去几千年的所有总和,数据采集、存储、处理和传播的数量也与日俱增。如何对数据进行有效的集成管理已成为行业关注的焦点。

数据集成2.0的现在时

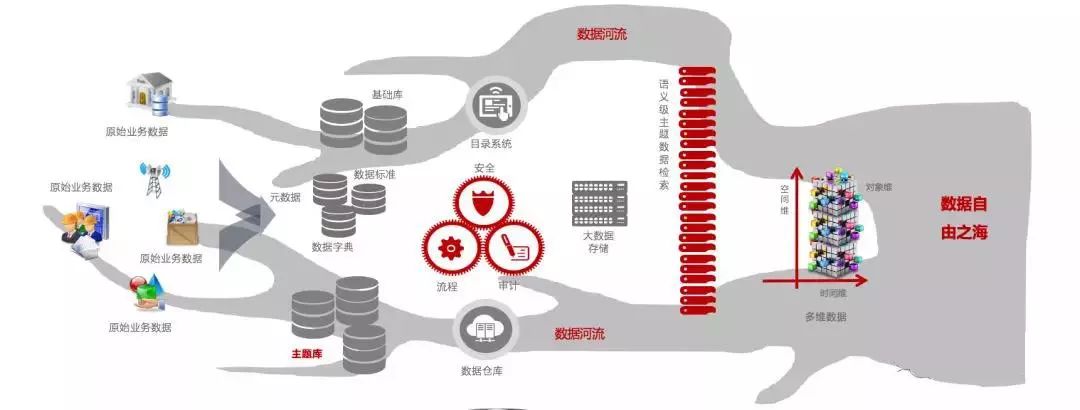

随着大数据、云计算、人工智能的快速落地,未来信息技术变化风云莫测,大数据、云计算、人工智能、区块链等技术的快速落地,也在加速数据集成形态发生改变。首先我们来举一个例子:某客户拥有上万个数据源,主要类型分为业务系统和物联网监控数据,根据发展需要把这些基础设施的数据和业务系统数据汇集到数据中心,数据中心的目标源主要有Mpp、Hive、HDFS、HBase等分布式存储源;如果每天需要把这些数据完成采集,需要每小时具备1TB数据处理能力;基于此客户抛出几个需求:

需求一

需要针对数据量进行实时增量同步,每小时需要具备处理增量数据5TB能力。

需求二

针对每类数据同步流量可实现流控,在必要时可牺牲一些无关紧要数据来保证整个数据集成平台的稳定运行。

需求三

客户希望面对复杂数据处理工作能够提供面向业务人员可操作的界面;减少实施人员环节,加快数据处理工作效率。

需求四

客户希望在使用过程中由于网络、断电、服务器崩溃等因素导致数据同步中断的时候,实现数据断点续传能力。

这几个需求是典型大数据时代数据集成面临的挑战,客户就是希望统通过技术手段实现数据实时治理,提升决策效率和数据价值。目前我们也正在处于这个时代,这个时期的数据集成产品如果要有竞争力,应该为数据集成赋予人工智能、分布式计算技术等能力;基于上述需求进行提炼,归结为以下几个特点:

基于人工智能技术实现数据开发设计,基于大数据技术实现海量数据实时采集、实时计算、实时同步;目前市面上有些厂商也逐步推出了新一代的数据集成平台产品,基本设计思路都是基于Kafka+分布式计算引擎(SparkStreaming+Storm+Filnk)+调度平台,实现新一代的数据集成平台全新技术架构,从目前这些厂商推出的产品,笔者也进行相关试用,无论是国外的还是国内的,平台还需要待完善;主要存在以下几个方面:

问题:目前数据接入都是标准接入能力,基于物联网的协议和数据库的实时增量,新一代的设备厂商大部分都解析成了文本数据,但是基于数据库的实时数据还是得需要平台自身提供能力,否则站在整个业务闭环的角度,实时集成的第一公里,这个平台是没有解决的。

解决方法:逐步增强输入源组件的能力,解决第一公里。

问题:新一代的数据集成平台大部分的组件使用较为复杂,大部分组件需要具备大数据技术能力和开发经验的人上手会比较快,其他运维和实施工程师学习成本较大。

解决方法:引入人工智能技术,傻瓜式的组件使用。

问题:数据集成平台采集大部分是未遵循相关标准,采集过程没有遵循相关配置规范,导致后续运维困难。

解决方法:引入数据标准体系,针对数据采集、数据处理、数据同步定义相关标准和规范,给数据开发定义软件工程设计思路,实现数据开发工程管理。

问题:针对数据采集过程中,数据时代,数据的价值和安全越发重要,数据集成平台依据互联网思维延伸过来,安全体系缺失,会出现严重泄露情况。

解决方法:做到“三权分立”的原则,即数据操作权、数据使用权、资源管理权;数据操作员依据资源管理员分配相关数据操作权限,数据使用员依据资源管理员的权限使用和查看相关数据,资源管理员只能知道平台具备什么资源,具体数据无法查看。

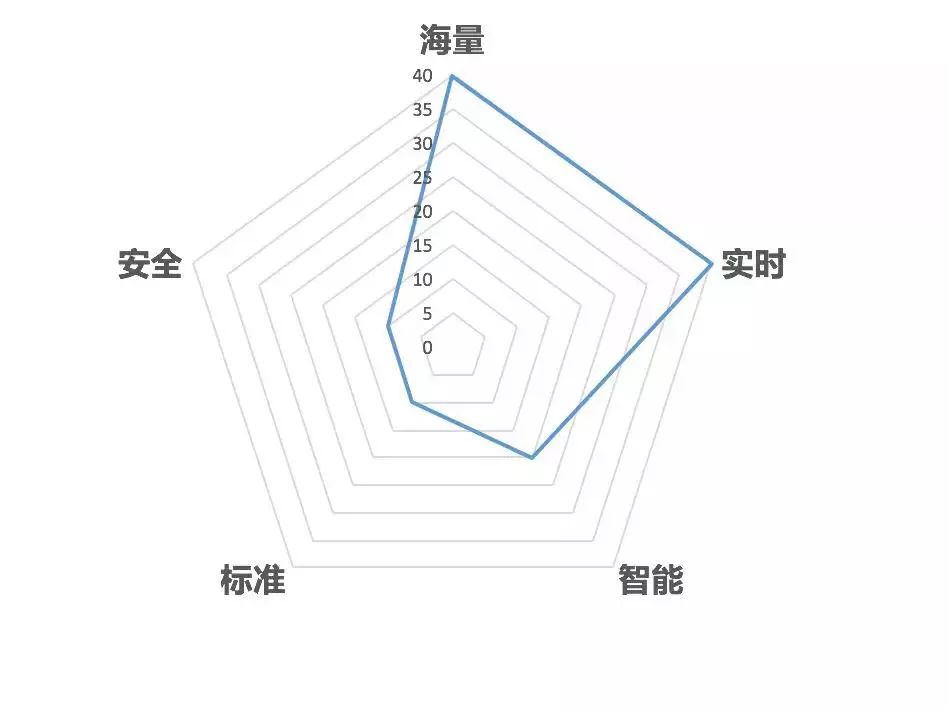

综上所述,新一代的数据集成平台用“海量、实时、智能、标准、安全”这五个关键词针对数据集成平台进行立体化的评估。

通过图中可以得出,在发展初期平台厂商目前更多主要基于海量数据处理和实时计算两部分进行了重点打造,另外三个板块还处于研究和探索阶段,预估在未来两年左右会趋向成熟。

数据集成3.0的未来史

全球智能手机的快速发展,推动了移动终端和“边缘计算”的发展。而万物互联、万物感知的智能社会,则是跟物联网发展相伴而生,边缘计算系统也因此应声而出。事实上,物联网的概念已经提出有超过15年的历史,然而,物联网却并未成为一个火热的应用。一个概念到真正的应用有一个较长的过程,与之匹配的技术、产品设备的成本、接受程度、试错过程都是漫长的,因此往往不能很快形成大量使用的市场。5G时代已经吹响号角,多家厂商密集发布5G手机 ,外加折叠屏等新技术带来潜在换机需求,出货持续下滑的智能机市场能否迎来一线生机,这个还需要市场检验。

前面加了一些偏离主题的内容,看似偏离,其实也是在引入一个问题,未来的数据集成平台还存在吗?如果存在,他将会是什么形态呢?我们可以结合行业发展趋势和信息技术发展情况进行大胆猜想。

根据Gartner的技术成熟曲线理论来说,在2015年IoT从概念上而言,已经到达顶峰位置。因此,物联网的大规模应用也开始加速。因此未来5-10年内IoT会进入一个应用爆发期,边缘计算也随之被预期将得到更多的应用。估计还是有人对这个词语比较陌生,按照百度百科的解释:“边缘计算是指在靠近物或数据源头的一侧,采用网络、计算、存储、应用核心能力为一体的开放平台,就近提供最近端服务”。

随着5G+边缘计算+区块链+云计算+人工智能等新技术快速商用,我们针对这个世界更加感知为一个由数据产生的信息时代;边缘计算解决就近应用问题,提升用户感知,区块链解决边缘计算与云计算中心的信息安全问题,5G解决双方之间的传输效率问题,人工智能技术应用到每一个边缘计算应用中,提升智能化商业应用落地。

数据集成平台主要解决异构数据源数据整合的问题,假如我们未来的相关应用基本按照标准的思路进行建设,还会存在异构源数据整合问题吗?答案是肯定存在的,我们大胆猜想,所有的应用已经完全标准化,所有行业的标准也规范化了,但是每个行业的标准必然是不一致的,未来可能存在某些行业的颠覆和消失,但一个国家的纲领必然存在,一个国家各个机构需要独立运转,那么运转的数据规范必然存在差异,有差异就需要数据治理,那么就需要针对数据进行融合。故未来数据集成平台必然还会存在,那么它将是以什么形态存在呢?

未来数据集成能力主要还是解决异构数据标准的整合问题,平台部分能力需要前移,交由前端应用完成,数据集成平台会考虑把维护的相关标准下发到各个应用中,而它尽可能的去实现标准管控的能力,尽量减少边缘计算应用与云计算之间的交互响应时间。